Nos últimos dias não se fala em outra coisa se não o DeepSeek. Alguns acreditam que destronaram o ChatGPT, mas eu sou cético. Então, nem só de software vive uma empresa: de estratégia, visão, gestão e gente sim, vive uma empresa. Mas não podemos negar que o feito chama atenção: mostraram que é possível melhorar os algoritmos e gerar modelos mais poderosos com menos hardware. Assim, imagine se eles tivesse o poderio da OpenAI com esses algorítmos? Bom, o artigo Instalando o DeepSeek em casa mostra de um jeito simples como instalar esse modelo para brincar você mesmo.

Então, além desse artigo, aqui no blog também temos diversos outros artigos sobre kubernetes, desenvolvimento, gestão, devops, etc. Veja alguns exemplos: Diferenças entre Paradigmas, Axiomas e Hipóteses, Desenvolver na empresa ou comprar pronto, Fuja da otimização prematura, entre outros.

Sumário

- Ollama no WSL

- Instalando o DeepSeek em casa – Encontrando modelos

- Instalando interface estilo ChatGPT para o Ollama

- Conclusão de Instalando o DeepSeek em casa

- Arquitetura Lambda e Arquitetura Kappa

- Formatos de serialização para bigdata

- O Essencial do Hadoop

- Os 14 tipos de bancos de dados

- Porque você precisa saber HTTP

- Banco de dados: Teorema CAP

- Bounded Contexts de dependência mútua

- Top 25 Ferramentas do Hadoop

Ollama no WSL

O Ollama é uma ferramenta que facilita a execução de modelos de IA de forma local, utilizando conceitos semelhantes aos do Docker. Assim, com ele, você pode baixar e rodar modelos diretamente em seu ambiente de casa. Desse modo, para quem o S.O. da Microsoft, o Windows Subsystem for Linux (WSL) é uma excelente opção para testar o Ollama sem precisar de uma máquina Linux dedicada. Talvez os artigos: Instalando o Linux no Windows ou Instalando o Docker no WSL2 possam complementar. Mais informações sobre o Ollama podem ser encontradas em https://ollama.com/.

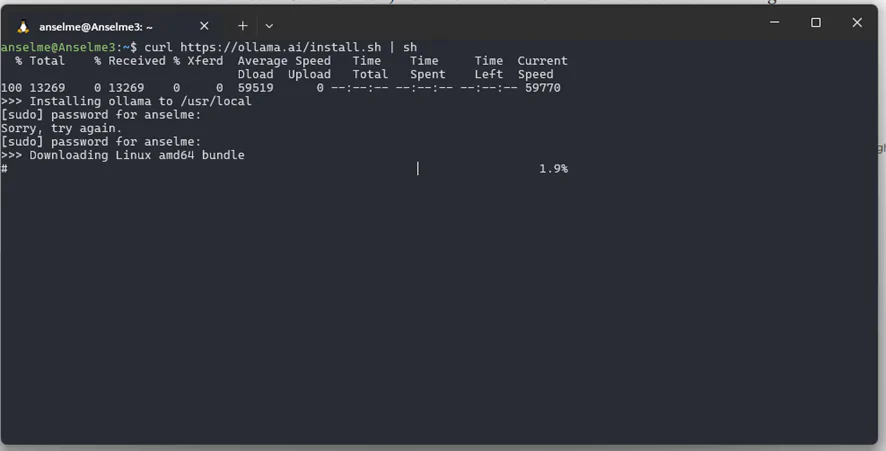

Instalando o Ollama

A instalação do Ollama é bastante simples. Basta rodar o seguinte comando:

curl https://ollama.ai/install.sh | shEsse comando baixa e instala automaticamente a ferramenta no seu ambiente.

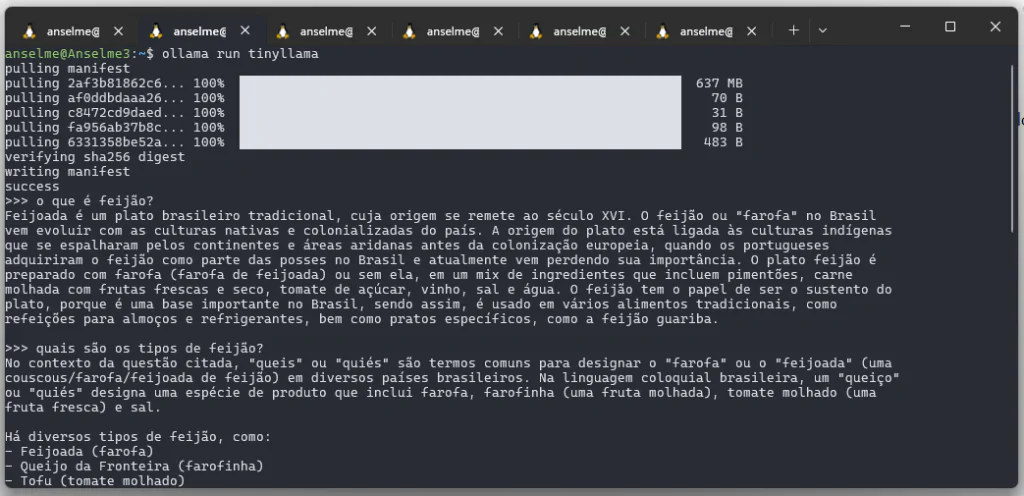

Instalando um modelo para testes

Para testar o funcionamento do Ollama, podemos instalar um modelo leve. Um bom exemplo é o TinyLLaMA, que tem 637MB:

ollama run tinyllama

Após a instalação, você pode fazer testes perguntando coisas simples como “o que é feijão”. Fique à vontade para realizar outras consultas e validar o funcionamento do modelo no seu computador.

Instalando o DeepSeek em casa – Encontrando modelos

A plataforma Hugging Face oferece milhares de modelos treinados, prontos para serem usados. No entanto, quando se trata do DeepSeek, seus modelos estão disponíveis no GitHub: https://github.com/deepseek-ai/.

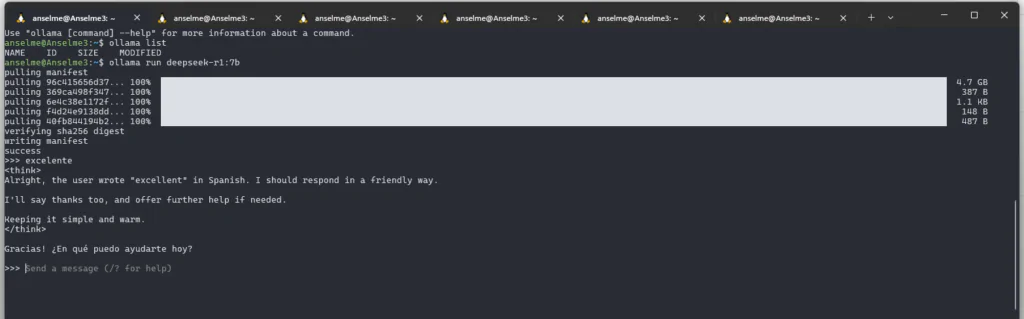

Entre os modelos mais destacados está o DeepSeek R1, que possui variantes desde 7B até 671B parâmetros. Para quem tem um computador sem GPU dedicada, modelos muito grandes não são uma opção viável. No meu caso, testei em uma máquina com 32GB de RAM e consegui rodar o modelo de 7B parâmetros sem problemas. Para instalar o DeepSeek R1 de 7B no Ollama, basta rodar:

ollama run deepseek-r1:7b

Instalando interface estilo ChatGPT para o Ollama

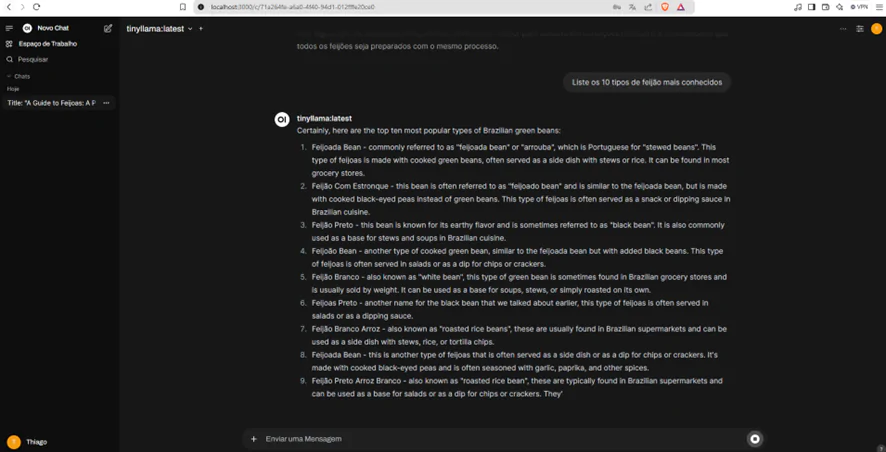

Para uma experiência melhor, podemos instalar a interface Open WebUI, que adiciona uma interface visual semelhante ao ChatGPT. Para rodá-la via Docker, use o seguinte comando:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Esse comando cria um contêiner com a interface e a conecta ao Ollama. Assim, você pode interagir com o modelo de forma mais intuitiva, diretamente pelo navegador.

Conclusão de Instalando o DeepSeek em casa

No artigo Instalando o DeepSeek em casa, mostramos como instalar e testar o DeepSeek em casa, utilizando o Ollama para facilitar a execução de modelos de IA. Assim, com uma abordagem simples, conseguimos rodar um modelo poderoso localmente e ainda adicionamos uma interface visual para melhorar a experiência. Então, se você tem interesse em exploração de modelos de IA, vale a pena testar diferentes tamanhos e configurações, considerando os limites do seu hardware. Agora é só brincar com as possibilidades e explorar o potencial do DeepSeek.

Ele atua/atuou como Dev Full Stack C# .NET / Angular / Kubernetes e afins. Ele possui certificações Microsoft MCTS (6x), MCPD em Web, ITIL v3 e CKAD (Kubernetes) . Thiago é apaixonado por tecnologia, entusiasta de TI desde a infância bem como amante de aprendizado contínuo.